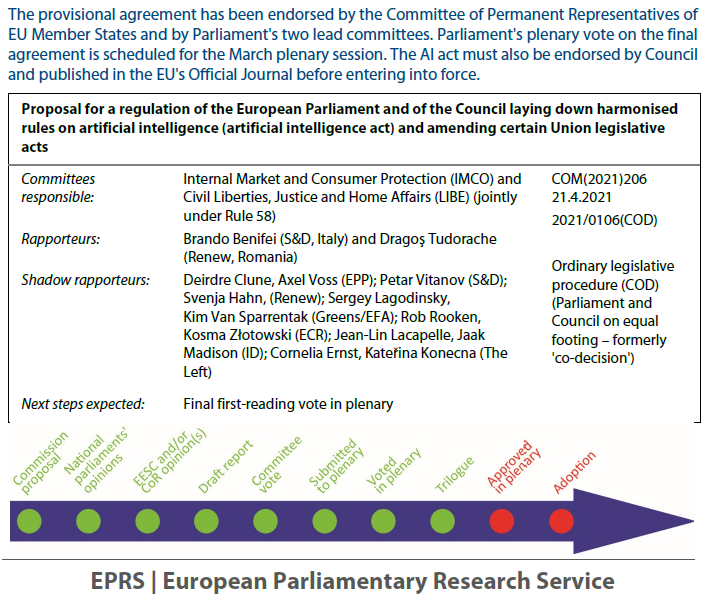

L’adoption de la loi sur l’Intelligence Artificielle (IA), par le Parlement européen, le 13 mars 2024, représente une étape majeure dans la régulation des technologies émergentes. En tant que premier cadre juridique complet au monde dans ce domaine, cette législation vise à limiter les risques associés à l’IA tout en positionnant l’Europe en tant que leader mondial dans le développement et l’utilisation éthique de cette technologie révolutionnaire.

Objectifs et portée de la loi sur l’IA

La loi sur l’IA vise à fournir aux développeurs et aux utilisateurs d’IA des directives claires et des obligations spécifiques pour garantir un déploiement responsable et éthique de ces systèmes. Elle s’inscrit dans un ensemble de mesures politiques plus larges visant à promouvoir une IA digne de confiance, comprenant notamment des initiatives pour l’innovation et une coordination renforcée dans le domaine de l’IA.

L’IA soulève en effet des questions éthiques importantes, notamment concernant les biais algorithmiques et la protection de la vie privée. Par exemple, les décisions prises par les systèmes d’IA peuvent influencer la vie des individus, de l’approbation de prêts hypothécaires à la détermination des peines de prison. La transparence et la responsabilité sont donc essentielles pour garantir un déploiement éthique de l’IA.

Les principales dispositions de la loi

Identification et interdiction des pratiques d’IA présentant des risques inacceptables :

La législation vise à identifier et interdire les pratiques d’intelligence artificielle qui présentent des risques inacceptables pour les individus ou la société dans son ensemble.

Établissement d’une liste d’applications à haut risque et définition d’exigences spécifiques pour ces applications :

La loi établit une liste d’applications d’IA considérées comme présentant un risque élevé, telles que les systèmes de reconnaissance faciale en temps réel, et définit des exigences spécifiques pour leur développement, leur déploiement et leur utilisation.

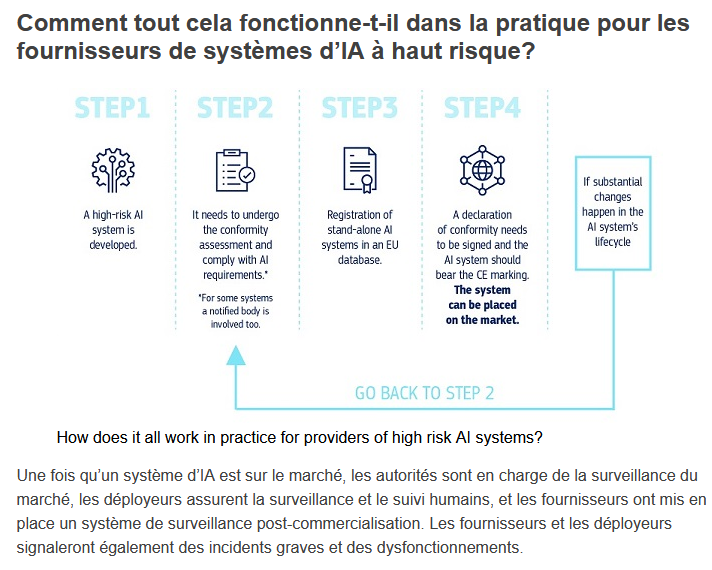

Obligations strictes pour les développeurs et les utilisateurs d’IA à haut risque, incluant des évaluations de conformité avant la mise sur le marché :

Les développeurs et les utilisateurs d’applications d’IA à haut risque sont soumis à des obligations strictes, notamment la réalisation d’évaluations de conformité approfondies avant la mise sur le marché ou l’utilisation de ces technologies.

Cadre de gouvernance européen et national pour superviser et réglementer l’utilisation de l’IA :

La législation prévoit la mise en place d’un cadre de gouvernance à la fois européen et national chargé de superviser et de réglementer l’utilisation de l’intelligence artificielle, afin de garantir un développement et une utilisation responsables de cette technologie.

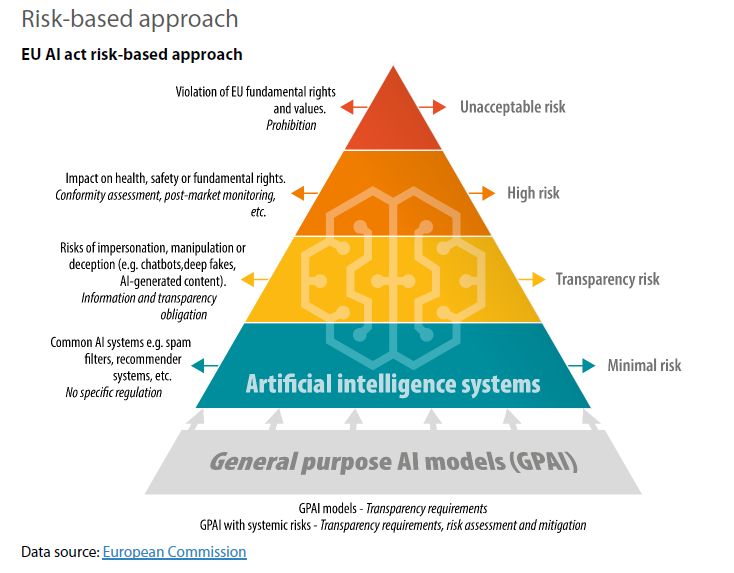

Une approche basée sur les risques

La loi sur l’IA définit quatre niveaux de risque pour les systèmes d’IA, avec des obligations proportionnées en fonction du niveau de risque. Les systèmes à haut risque, tels que ceux utilisés dans les infrastructures critiques ou l’emploi, sont soumis à des obligations strictes pour assurer leur sécurité et leur conformité aux normes éthiques.

La loi sur l’IA adopte ainsi une approche graduelle en définissant quatre niveaux de risque pour les systèmes d’IA, chacun étant assorti d’obligations spécifiques pour assurer leur conformité et leur sécurité.

- Risque Inacceptable : Les pratiques d’IA présentant un risque inacceptable, telles que la notation sociale par les gouvernements ou les jouets encourageant des comportements dangereux, sont explicitement interdites.

- Risque Élevé : Les systèmes d’IA utilisés dans des domaines sensibles tels que les infrastructures critiques, l’éducation ou l’emploi sont considérés comme à haut risque. Pour ces systèmes, des obligations strictes sont imposées, telles que des évaluations approfondies des risques, des ensembles de données de haute qualité, et des mesures de surveillance humaine pour minimiser les risques.

- Risque Limité : Ce niveau de risque concerne les systèmes d’IA où le principal enjeu est le manque de transparence. Afin de garantir la confiance des utilisateurs, des obligations de transparence sont introduites, obligeant les fournisseurs à informer les utilisateurs lorsqu’un système d’IA est utilisé et à garantir l’identifiabilité du contenu généré par l’IA.

- Risque Minimal ou Nul : Les systèmes d’IA à risque minimal, tels que les jeux vidéo ou les filtres anti-spam, bénéficient d’une utilisation plus libre. Ces applications sont soumises à des exigences moins contraignantes en matière de réglementation, permettant une innovation plus fluide et un accès plus facile au marché.

Bien que la législation représente une avancée significative dans la régulation de l’IA, elle présente encore des défis, notamment en ce qui concerne sa mise en œuvre pratique et son impact sur l’innovation et la compétitivité des entreprises.

Transparence et responsabilité

La législation met également l’accent sur la transparence et la responsabilité dans l’utilisation de l’IA. Les fournisseurs doivent informer les utilisateurs lorsque des systèmes d’IA sont utilisés, et garantir que les décisions prises par ces systèmes sont explicables et justifiables.

De plus, les incidents graves et les dysfonctionnements doivent être signalés aux autorités compétentes.

Vision à long-terme

Consciente de l’évolution rapide de la technologie, la loi sur l’IA adopte une approche qui se souhaite à l’épreuve du temps, permettant une adaptation continue aux changements technologiques.

Un Office européen de l’IA supervisera l’application de la loi et favorisera la collaboration internationale pour une gouvernance de l’IA alignée à l’échelle mondiale.

La régulation de l’IA sera en effet nécessairement un processus continu et évolutif. La législation devra s’adapter aux progrès technologiques et aux nouveaux défis éthiques qui émergent. Une collaboration internationale sera donc également essentielle pour assurer une gouvernance cohérente et éthique de l’IA à l’échelle mondiale.

Catégorisation des modèles d’IA et impact sur la recherche

Un article de Nature examine aussi en détail la récente adoption de la loi sur l’Intelligence Artificielle (IA) par l’Union Européenne et met en lumière ses différents aspects et son impact sur la recherche, l’innovation et l’utilisation éthique de l’IA dans l’ensemble de l’Union européenne.

L’article met ainsi en évidence deux aspects clés de cette loi.

- Premièrement, il souligne la catégorisation des modèles d’IA en deux niveaux, distinguant les modèles à haut impact nécessitant des obligations supplémentaires, telles que des tests de sécurité rigoureux et des vérifications de cybersécurité.

- Deuxièmement, il explore l’impact de la loi sur la recherche en IA, mettant en avant la nécessité pour les chercheurs de se conformer aux exigences de transparence et de signaler les éventuels biais dans leurs modèles.

La promotion de l’open source

En outre, l’article souligne l’importance de la promotion de l’open source dans le cadre de cette législation, en encourageant la disponibilité et la transparence des informations sur les modèles d’IA. Cette approche vise à favoriser la collaboration et l’innovation dans le domaine de l’IA.

IA généraliste et générative

Comme l’indique la Commission Européenne, “l’IA générative, comme ChatGPT, devrait se conformer aux exigences de transparence :

• indiquer que le contenu a été généré par l’IA

• concevoir le modèle pour l’empêcher de générer du contenu illégal

• publier des résumés des données protégées par le droit d’auteur utilisées pour la formation

Les modèles d’IA à usage général à fort impact susceptibles de présenter un risque systémique, tels que le modèle d’IA plus avancé GPT-4, devraient faire l’objet d’évaluations approfondies et signaler tout incident grave à la Commission.”

Les prochaines étapes

La loi sur l’IA entrera en vigueur après sa publication officielle, avec une période de transition pour permettre aux entreprises de se conformer aux nouvelles obligations.

En parallèle, le “Pacte sur l’IA” encourage la mise en œuvre volontaire des principales obligations de la loi pour faciliter la transition vers ce nouveau cadre réglementaire.

La loi sur l’IA représente donc une avancée significative dans la régulation des technologies émergentes en Europe, s’efforçant de garantir un développement et une utilisation responsables de l’IA pour le bien des personnes, de la société et de l’économie. Mais il reste encore à voir l entrée en vigueur de ses applications et quelques questions en suspens, ce qui nécessitera une vigilance continue de la part des législateurs, des chercheurs et de la société dans son ensemble.

Ce qu’il faut en retenir :

1.La loi sur l’IA représente le premier cadre juridique complet au monde pour réguler l’utilisation de l’Intelligence Artificielle, positionnant l’Europe en tant que leader mondial dans ce domaine.

2. Elle établit des obligations claires pour les développeurs et les utilisateurs d’IA, notamment en identifiant les applications à haut risque et en imposant des exigences strictes pour leur mise sur le marché.

3.La législation met l’accent sur la transparence, la responsabilité et la sécurité dans l’utilisation de l’IA, tout en adoptant une approche flexible pour s’adapter aux évolutions technologiques futures.

Les questions en suspens :

-La mise en œuvre pratique de la loi sur l’IA

-Son impact sur l’innovation et la compétitivité des entreprises.

-Les défis liés à la surveillance et à la réglementation des modèles d’IA à usage général, ainsi que leur impact sur la vie privée et les droits individuels.

-La nécessité d’une collaboration internationale pour assurer une gouvernance cohérente et éthique de l’IA à l’échelle mondiale, tout en préservant la souveraineté et les intérêts des États membres de l’UE.

Pour aller plus loin:

Notre article sur “Les nouvelles frontières du Droit : réflexions sur l’I.A. (intelligence artificielle), l’économie circulaire, le réchauffement climatique et d’autres défis émergents“

L’article du Parlement Européen sur la “Loi sur l’IA de l’UE : première réglementation de l’intelligence artificielle”

L’article de la Commission Européenne : Bâtir l’avenir numérique de l’Europe – Loi sur l’I.A.

L’article de Nature “What the EU’s tough AI law means for research and ChatGPT“